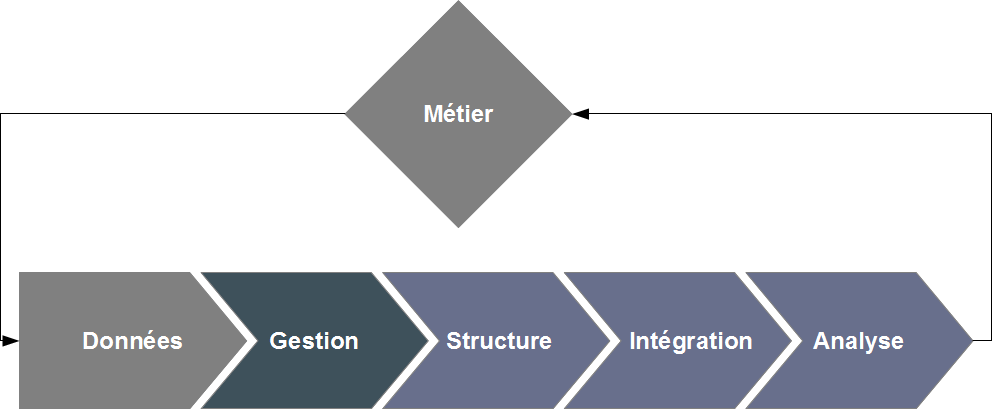

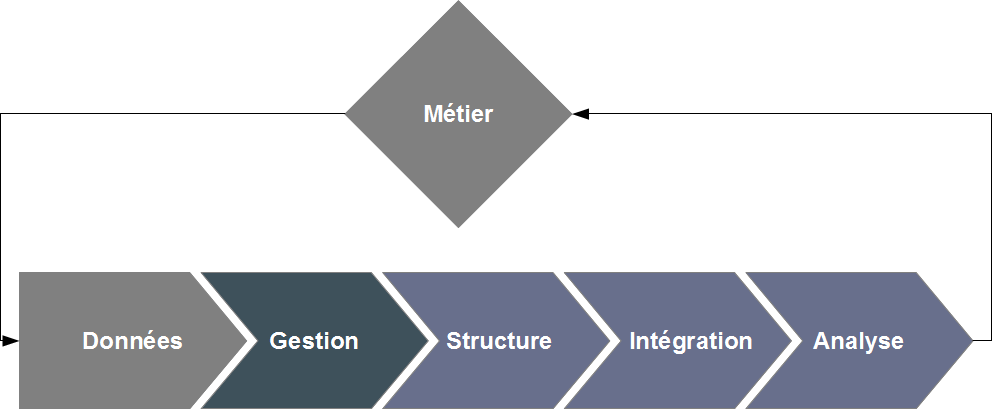

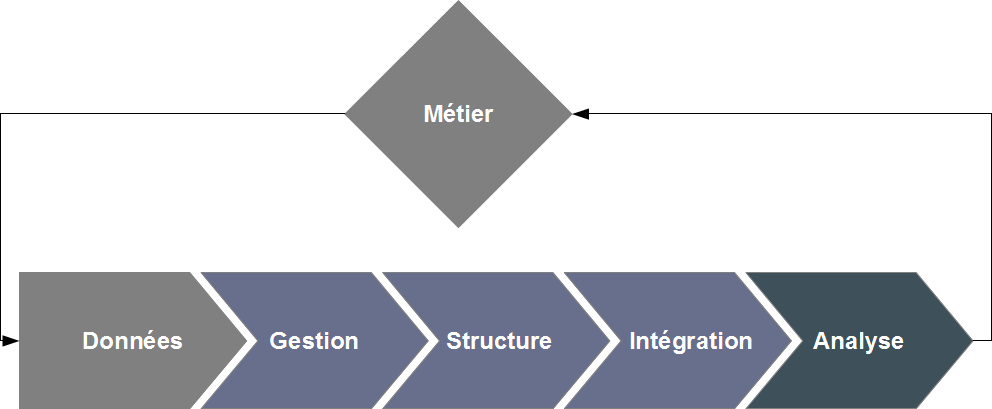

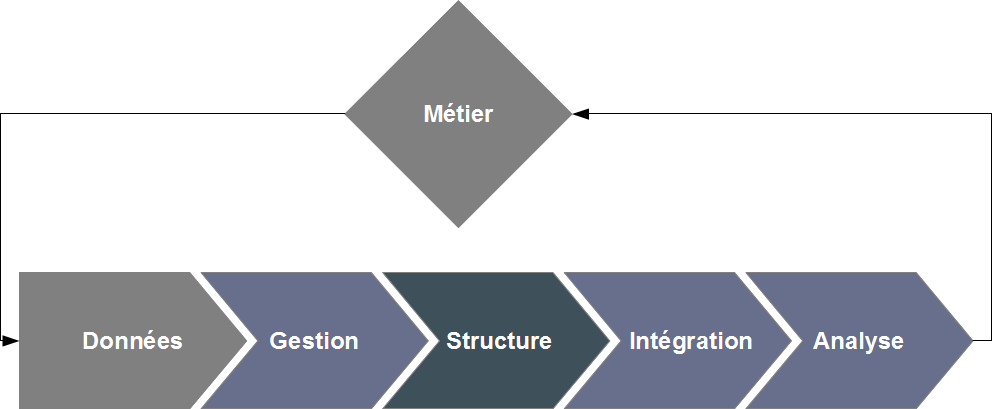

Le cycle de vie des données

Sycomor met à votre disposition son expertise du traitement de l'information pour des missions ciblées.

Dans la plupart des projets numériques, l'information, la donnée, et la connaissance sont les "matières premières" manipulées, transformées, raffinées. Le cycle de

vie de la donnée inclut des besoins de stockage, de traitement, d'analyse, de restitution, d'intégration, de valorisation. A chaque étape, Sycomor vous soutient dans l'amélioration des pratiques,

l'optimisation des processus, et la découverte de nouvelles opportunités d'évolution.

Une mission d'expertise peut être réalisée de manière autonome, ou s'intégrer à une réflexion plus globale stratégique (comment valoriser la donnée ?), méthodologique (quelles

procédures mettre en place pour en garantir l'intégrité ?) ou opérationnelle (quels outils pour le traitement de la donnée ?).

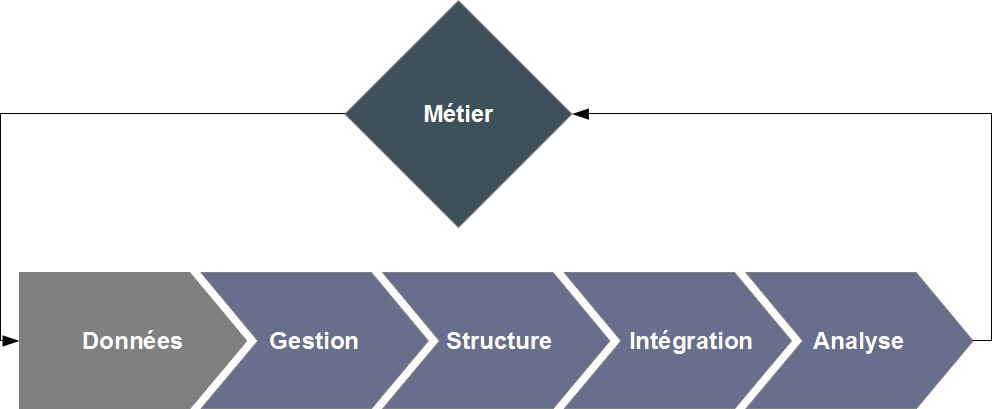

La problématique Big Data

Le phénomène big data, actuellement omniprésent dans les media informatiques, explore une problématique bien réelle et représente un changement de paradigme

majeur pour une entreprise. Le concept s'articule autour de la gestion de jeux de données dont la taille toujours croissante rend les traitements et outils

habituels peu adaptés. Ces questions concernent de nombreux domaines fonctionnels, notamment les sciences de la vie, l'analyse financière, la physique et

le traitement de données informatiques (internet). La croissance exponentielle des données associées conduit à une adaptation, voire une réinvention des

méthodes informatiques de gestion.

Notre connaissance approfondie des problématiques big data et des technologies associées nous permet de vous

soutenir dans l'évaluation de vos besoins et la sélection de solutions adaptées pour l'ensemble des axes potentiels d'amélioration.

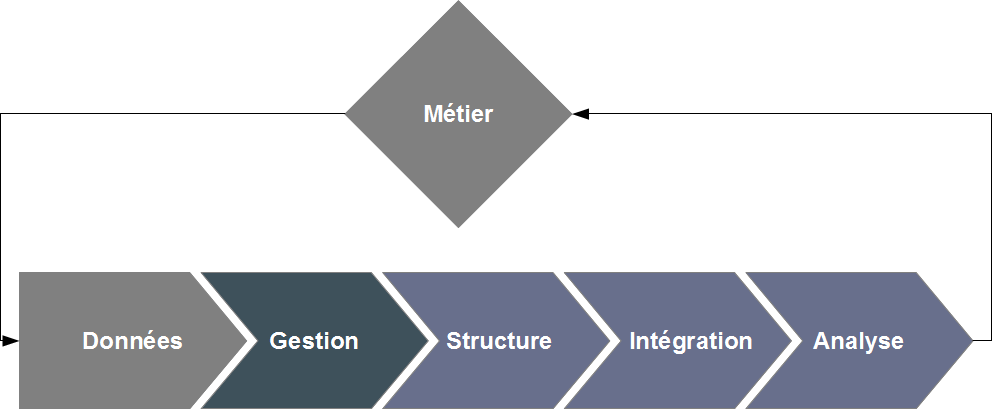

Composants d'expertise

Stockage et traitement : sans doute la problématique la plus spécifique du paradigme big data. Systèmes de fichiers distribués, stockage

virtualisé (cloud), bases de données "nosql" spécialisées... Les composants nécessaires à une gestion de données de grande taille sont nombreux et nécessitent

une expertise adaptée ; ce socle technologique est indispensable à la mise en place de procédures de traitement de l'information, qui impliquent à leur tour des

évolutions de la pratique (parallélisation) autant que des méthodologies (par exemple : solutions algorithmiques type MapReduce).

Analyse : classification supervisée et semi-supervisée, classification non

supervisée, apprentissage statistique, systèmes complexes, détection d'anomalies et de motifs récurrents... Si la plupart de ces outils d'analyse ne sont pas

spécifiques à la problématique big data, le volume de données à manipuler rend leur nécessité d'autant plus aiguë et le choix de techniques adaptées peut s'avérer

critique dans la valorisation de vos données.

Curation : traitement automatisé, structuration de l'information, traitement du

langage naturel... Cette facette s'avère également nécessaire quand la curation manuelle présente un coût prohibitif au regard de la volumétrie des données.

Intégration : idéalement adossée à une gestion structurée de la connaissance, l'intégration de données hétérogènes est une étape indispensable de leur

valorisation en facilitant l'interopérabilité de vos solutions informatiques et l'échange d'informations pertinentes.

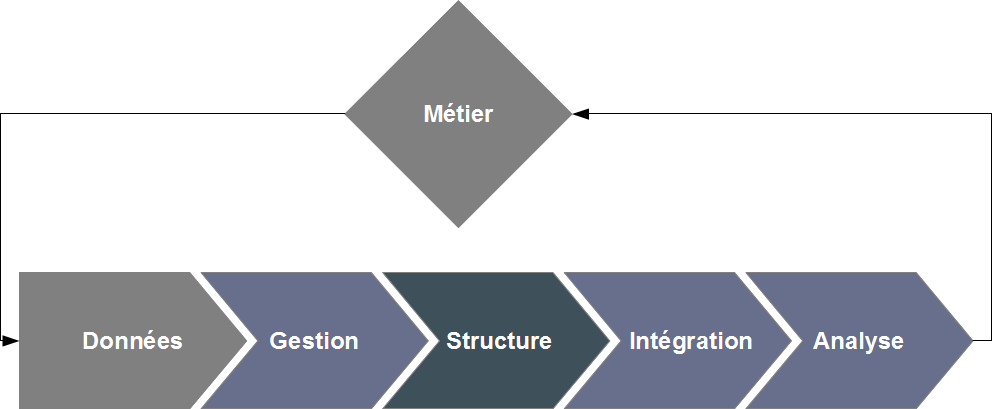

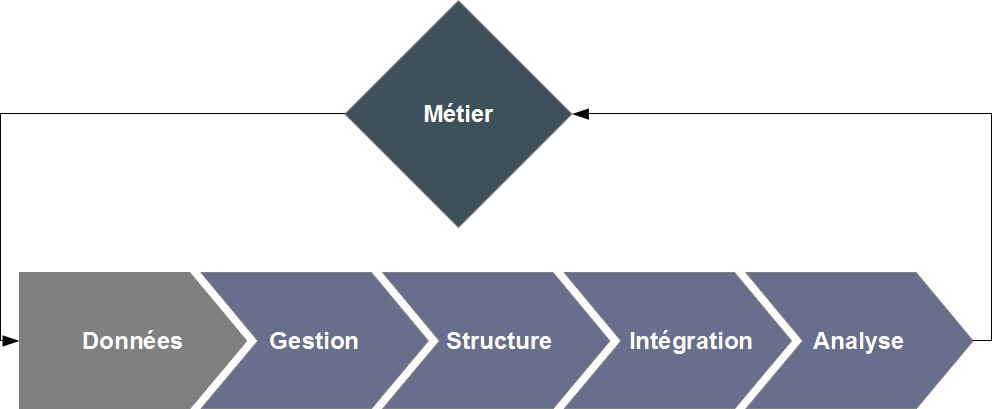

Gestion des savoirs et structuration de la connaissance

La gestion des savoirs (knowledge management) regroupe l'ensemble des méthodes et techniques destinées à organiser, traiter,

partager et représenter le savoir collecté au sein d'une structure (votre entreprise), qu'il ait été généré en interne ou acquis à l'extérieur.

De manière générale, l'introduction d'une gestion de la connaissance au sein de votre entreprise permet de valoriser le savoir implicite en le rendant

accessible à tous. Sa codification, en interaction avec les solutions informatiques adéquates, permet ensuite de systématiser son application, de l'étendre,

et potentiellement de l'utiliser comme une nouvelle source de valeur, parce qu'il peut désormais être traité comme une donnée à part entière et exploitée par

des outils adaptés.

Notre expertise dans l'intégration de solutions de gestion de la connaissance à des systèmes d'informations nous

permettra de vous accompagner dans la formalisation de vos savoirs et vos choix d'implémentation.

Éléments d'implémentation

En pratique, la gestion des savoirs se situe à la confluence de plusieurs domaines qui devront interagir et collaborer :

- la composante humaine (vos équipes) sera à la fois la première productrice de savoir, et la source de la formalisation.

Organisée en groupes d'intérêts ou de pratique, elles permettront une première définition des concepts clés et de leur application à votre métier et

vos données.

- la structuration de la connaissance sera développée par la création, ou l'utilisation d'ontologies

(représentation formelle des connaissances et de leurs relations) relatives à votre métier.

- l'exploitation de cette connaissance sera réalisée à l'aide d'un système d'information adapté, qui empruntera également à

des domaines spécialisés, tels que le traitement du langage, pour mettre en relation connaissance formelle et données, par l'annotation (manuelle ou

automatisée) par exemple.

- la valorisation de cette connaissance pourra enfin être amenée par l'adjonction d'outils d'analyse de données qui tireront parti de cette connaissance-donnée désormais traitable par voie

informatique pour découvrir des motifs ou anomalies jusqu'ici indétectables.

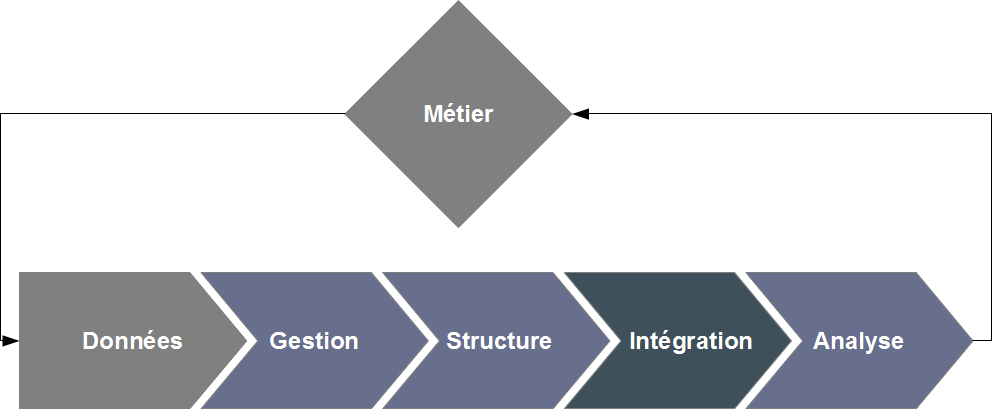

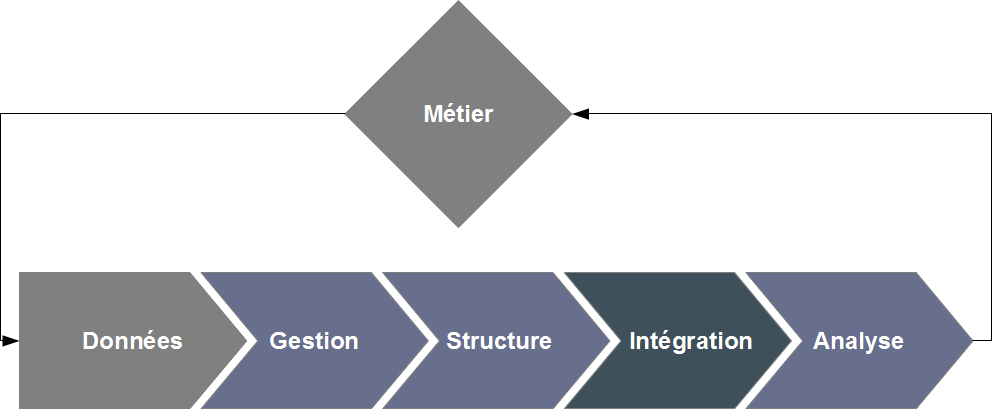

Pratique de l'intégration de données

L'intégration de données consiste à combiner des informations provenant de sources multiples afin d'en donner une vision unifiée à

l'utilisateur. La nécessité d'une telle étape de traitement croît rapidement, au fur et à mesure que la quantité de données, leur complexité, leur

hétérogénéité, et le nombre de fournisseurs potentiels grandissent.

Notre maîtrise de l'intégration de données hétérogènes nous permet d'intervenir sur l'ensemble des étapes de

mise en place d'une solution complète, tenant compte des spécificités de votre domaine fonctionnel et de vos pratiques.

Processus d'intégration

La mise en place d'une telle solution devra répondre à un certain nombre de questions dont les réponses doivent être adaptées à votre environnement :

- Modélisation : une étape préliminaire consistera en une modélisation conjointe des données, afin de déterminer les

"ponts" pré-existants qui permettront d'assurer leur jonction.

- Stratégie d'intégration : en fonction de la complexité des données et de l'accessibilité des fournisseurs, les stratégies

classiques d'entrepôt ("ETL" : Extract - Transform - Load) pourront être remplacées par un couplage plus léger, chaque source devenant un

fournisseur virtuel (par exemple, via web-services) d'information en temps réel.

- Mise à disposition : l'utilisation prévue des données peut par exemple nécessiter une centralisation (développement d'un

client dédié) ou un réseau d'interactions entre les outils existants (interopérabilité).

- Soutien sémantique : toutes les phases précédentes pourront fortement bénéficier d'une formalisation des concepts telle

que la gestion des savoirs peut le permettre. Cette approche permettra

de structurer de manière non-ambiguë les données destinées à transiter. C'est le concept sous-jacent au web sémantique.

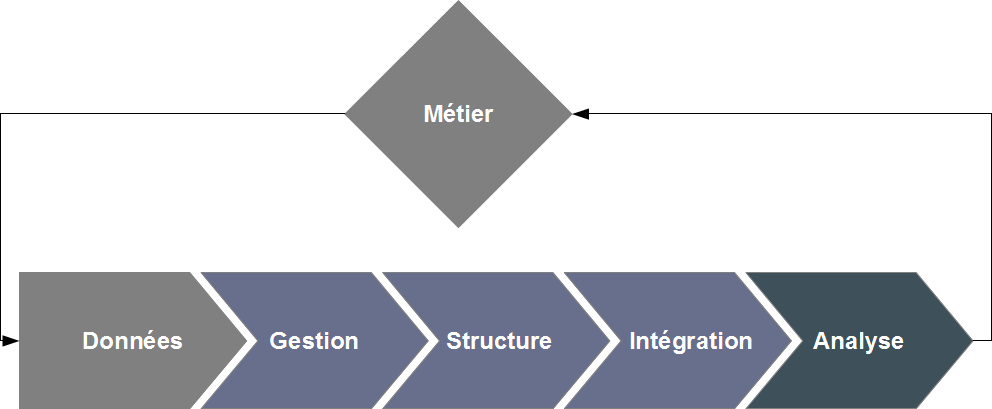

Applications générales de l'analyse de données

L'analyse de données consiste en l'application d'outils mathématiques, statistiques et algorithmiques à des données afin d'en tirer des

enseignements représentant une valeur ajoutée : découverte de connaissances nouvelles, validation ou invalidation d'hypothèses, aide à la prise de décision,

optimisation de paramètres...

Notre pratique de l'analyse de données nous permet d'adapter l'outillage

analytique au domaine fonctionnel et au besoin exprimé afin de traiter vos problématiques de valorisation de l'information.

Quelques exemples de réalisations

Les questions pouvant être résolues à l'aide de ces techniques sont innombrables. On pourra par exemple envisager les approches

suivantes :

- classification supervisée ou semi-supervisée pour la dissémination d'informations sur un ensemble de données ;

- classification non-supervisée pour l'exploration de données et leur regroupement en classes de similitude ;

- optmisation de paramètres pour l'amélioration des processus ;

- recherche de modèles explicatifs ou approximatifs pour permettre la prédiction de données ;

- modélisation et simulation à des fins d'analyses de scénarios ou de génération d'hypothèses ;

- etc.

Idéalement intégrée dans un processus de traitement complet (en amont :

intégration

des données,

structuration de la connaissance ; en aval : système

d'information et outils de visualisation), et sans minimiser le coût calculatoire potentiellement élevé (certaines questions ne peuvent être résolues en

temps réel et nécessitent l'accès à des fermes de calcul - réelles ou virtualisées -), l'analyse de données peut répondre à de nombreux besoins et

aboutir à des gains qualitatifs ou quantitatifs substantiels pour votre activité métier.

Les sciences de la vie comme domaine fonctionnel

Le domaine des sciences de la vie présente une rare complexité par les problématiques qu'il aborde (de la biologie exploratoire à la

pratique thérapeutique, de la compréhension du vivant au traitement de la pathologie), les métiers qu'il englobe et fait interagir, la richesse des informations

qu'il manipule (que ce soit en termes d'hétérogénéité, de dimensionnalité ou de volume). Pour toutes ces raisons, une approche rationnelle, structurée et

systématique est indispensable dans le traitement informatique de ces données; la profusion de solutions logicielles pour l'analyse, la gestion de

l'information, ou encore la structuration de la connaissance biologique est un marqueur indéniable de ce besoin.

Sycomor dispose d'une longue expérience de réalisation de projets informatiques en sciences de la vie. Au-delà

de nos axes d'expertise, déjà mentionnés, nous mettons à votre disposition notre maîtrise du domaine, de son langage et de ses codes. Nous pourrons

ainsi intervenir sur l'ensemble de vos problématiques et vous fournir les éléments décisionnels nécessaires à la résolution de vos besoins.

Quelques exemples d'interventions en sciences de la vie

- conception, management, et développement de systèmes d'information logiciels industriels ;

- conception et développement d'outils innovants d'analyse de données hétérogènes (génomiques, protéomiques, phénomiques,

etc.) ;

- conception et implémentation de structures d'intégration de données hétérogènes (cliniques, génomiques, protéomiques,

phénomiques, etc.) ;

- conception et réalisation d'outils d'annotation structurée basés sur le traitement du langage naturel et la formalisation

de la connaissance à l'aide d'ontologies adaptées ;

- conception d'une "superstructure" orientée big data.